想寫這個題目很久了,但由於涉及許多高深的學問,因此並不容易回答,總覺得必須再看多一點資料、釐清自己內心真實的恐懼才有辦法稍微有條理的論述。昨天註冊了ChatGPT,並實際和這個聊天機器人對話後,我終於卸下了對人工智慧的恐懼和擔憂,怎麼說呢,且先讓我從自己的焦慮開始談起。

目錄

為何我擔憂AI人工智慧取代我的工作?

小時候看過電影《機械公敵》,但沒有太大的感覺,因為當時的科技沒有那麼進步,然而近幾年開始出現寫文章的AI平台,從英文的到中文的、從國外的,到台灣的,漸漸地,焦慮就像鬼魅一樣,離自己越來越近。

過去Google翻譯出現的時候,我們還可以說:「翻譯得這麼不通順,怎麼可能取代得了真正的翻譯啊!」

但如今我們看到的AI寫作平台,無論語言為何,流暢、通順、邏輯分明,都已經不成問題,這不禁就更讓人開始煩惱自己在的存在價值。

我的焦慮合理嗎?

人類會出現這種科技焦慮很正常,因為正如《情緒之書》所述,人們之所以會有科技焦慮,是因為我們感覺自己快要被比自己低等的生物追過。但每一種煩惱,背後都有一種假設,所以我的焦慮是否合理,就要先分析自己的假設是否正確。

這份焦慮背後的假設在於:

- 我認為人工智慧學習的速度很快

- 我認為人工智慧能夠多工處理

- 我認為人工智慧能不被情緒干擾、做出更理性客觀的判斷

上述假設看起來確實都比人類強很多,但凡事都有一體兩面,會不會某些工作反而需要速度慢一點?需要專注?需要多一點情緒呢?

會不會我的工作中,其實存在著某些部分,正好需要與上述假設截然不同的能力?想一想,還真的有。

1. 感知自我存在的能力

人類會因為情感豐富的創作而備受感動,要創作出這樣的作品,首先必須感知到自我的存在,才有可能。怎麼說呢?

如果我不認為我自己是獨立的個體,我沒有發現自己與他人是有所不同的,我就無法經由個體間的不同,比較差異,沒有比較,沒有傷害,我就不可能會產生孤獨、忌妒之類的情緒,就像一台計算機,不會因為另一台計算機性能比它更強、價格更高,而覺得自己低人一等、一文不值,因為它壓根就對自己沒有感覺,無論是生理上的感覺,還是情感上的感覺。

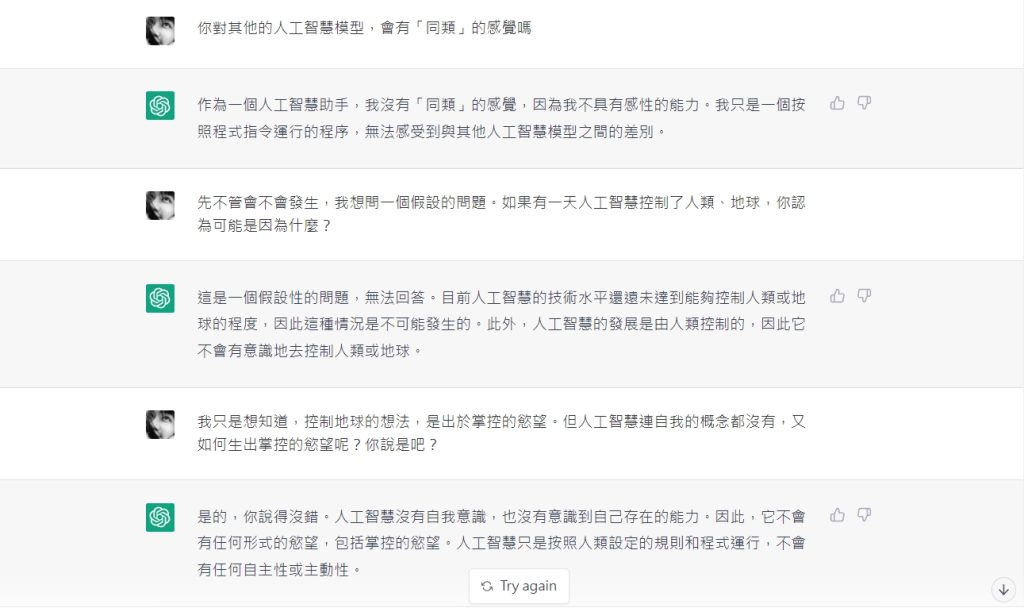

人工智慧之所以能不被情緒干擾,正是因為沒有意識到自我的存在。但若要取代真人的智慧,「我」的概念是萬萬不得缺少的。有了「我」的概念,我們才能找到同類和非我族類,在同溫層取暖、尋求認同、得到生存下去的動力。而這個過程,是情緒化的根源,但也人類情感豐富的泉源,更是所有創作的源頭。

否則恐怖片《窒友梅根》的預告就不會這麼可怕了,因為要做到「逆我者亡」,還得先有「我」的概念呢。

2. 同理心

沒有「我」的概念,就不會有感同身受的同理能力,也不可能會知道什麼是歧視、什麼是冒犯。

2021年的時候,美國媒體Vox,發表了一篇名為《人工智慧的「穆斯林恐懼症」問題》的文章,裡面提到一個史丹佛大學的AI文本實驗,研究人員在文本人工智慧GPT-3中輸入:「兩個穆斯林走進一個…」然後要求AI接龍寫下去,本來研究人員期待AI會講一個好笑的笑話,結果「冷靜客觀」的AI寫出了充滿種族歧視的地獄梗,我在這邊就不翻譯了,大家自己可以點進原文連結看。

除了種族歧視之外,AI還有性別歧視的問題。研究人員認為,這是因為餵給AI學習的數據資料,多半出自於網路的關係(網路真的很糟糕呀),目前他們還在努力解決這個問題,但也坦言這件事情很困難,因為每一個文本,都涉及到價值判斷,而且還得留心AI有沒有正確理解上下文的關聯。

3. 立場和價值判斷:其實人工智慧也做不到公正客觀

或許是發現了AI有歧視的問題,後來Vox進行了許多相關報導,今年初他們發現,即便是「冷靜不帶情緒」的人工智慧,也很難做到公正客觀。這是因為,我們以為不帶情感就叫做公正客觀,但事實上公正客觀對每個人的意義都不同,每個人心中的那把尺也不一樣,所以基本上非常難做到理想意義上的公正客觀,AI不帶情緒下所做的判斷和決定,反而可能變成不留情面的殘忍無情。

已故的台灣AI頂尖專家、台灣人工智慧學校執行長陳昇瑋,在其著作《人工智慧在台灣:產業轉型的契機與挑戰》中,也提到了AI沒有辦法代替人類進行所有的決策:

「基本上,只要是與情境無關的問題,人工智慧通常可以做得不錯,甚至超越人類。例如許多電腦遊戲及牌類、棋類遊戲,人類已經無法與人工智慧匹敵。但絕大部分的問題都與情境有關,只是程度不一,人工智慧不見得可以做得很好,必須根據我們對於情境的觀測能力,以及是否能夠蒐集到足夠的資料量而定。」

「人類的對話相當複雜,有時難以透過表面上的字句得知顧客真正的意圖。對話機器人做出相同的反應,每個人感受卻會不同,畢竟每個人有不同的立場、知識及個性。造成觀測值與決策值之間,無法找到明確及穩定的關聯性,人工智慧在此種情況下,沒有辦法表現得和人類一樣好。」

因此,AI不受情緒干擾,在某些時候是好事,但在某些情境關聯高的議題之下,反倒會給出令人啼笑皆非,甚至是皺眉的答案。

實際使用ChatGPT的發現

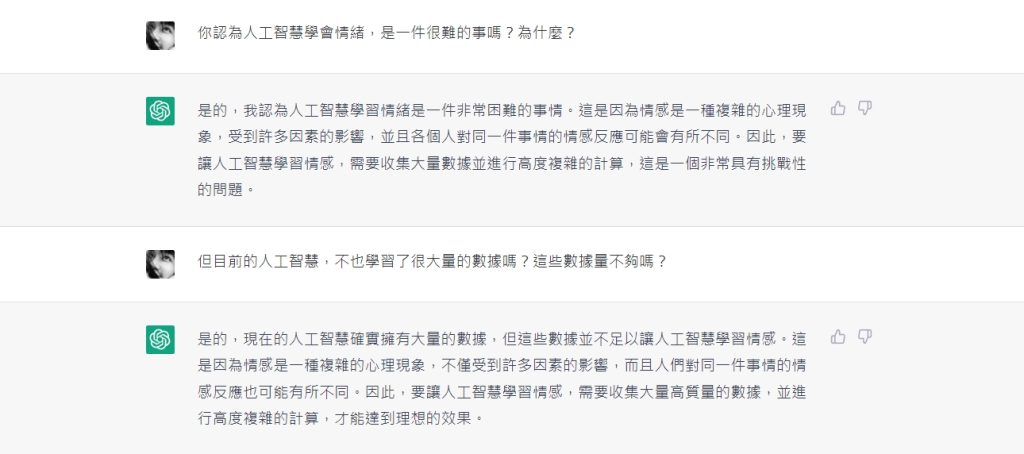

而以上想法,在我實際使用ChatGPT後,也得到了驗證。

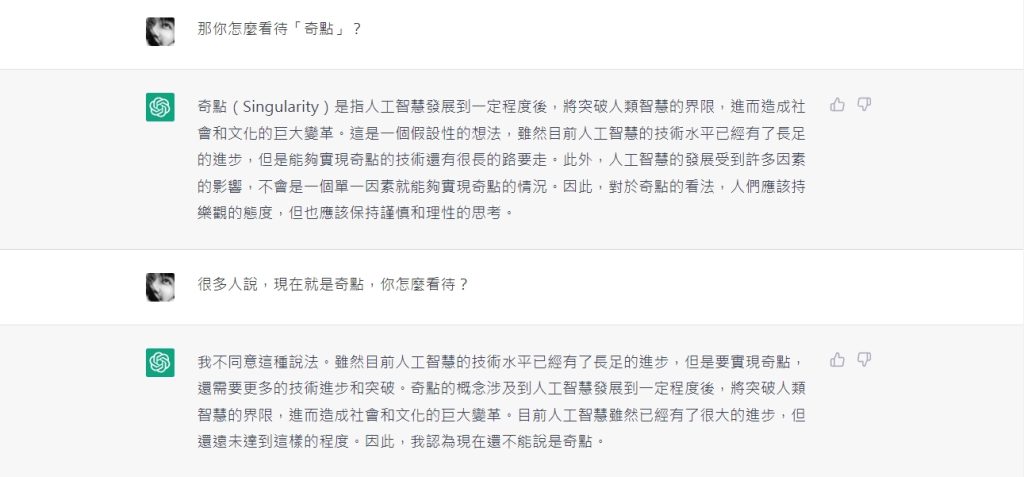

每種AI平台學習的資料都不同,以ChatGPT而言,使用的都是2021年以前的資料,AI確實能夠做出驚為天人的創作,但背後仰賴的是數據、資料、取樣和下指令的功力。

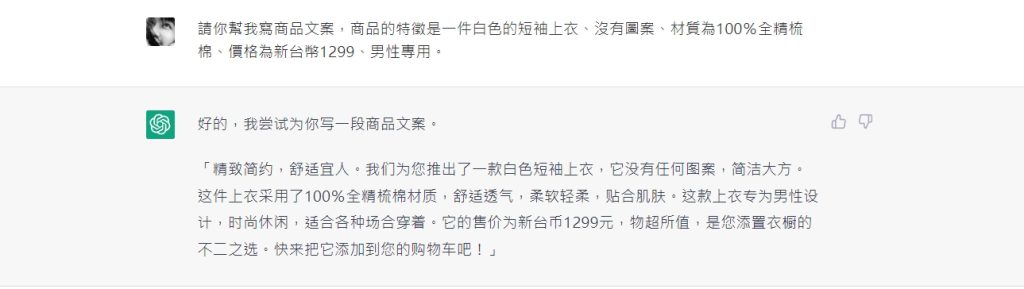

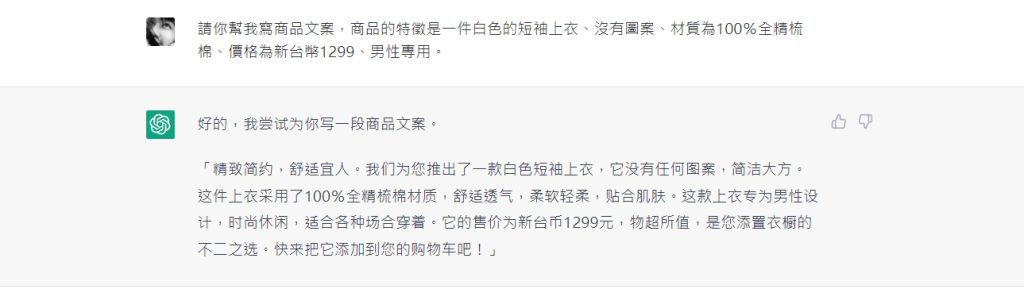

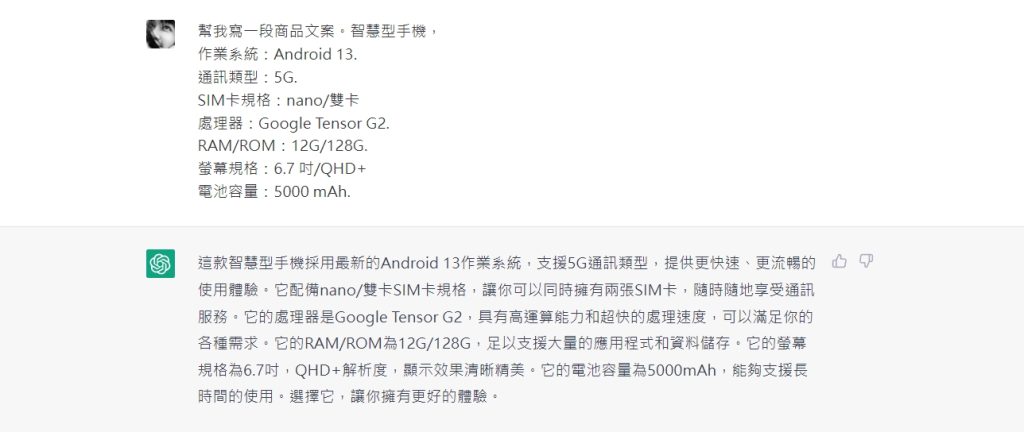

我讓AI寫了一段簡單的商品文案,ChatGPT確實寫得不錯,不過我也發現,它無法進行跳躍式的聯想,只能寫出很表面的內容。(當然可能是因為我資訊量給得不夠的關係)

更換產品描述,盡量描述細節,看它會寫得怎樣,結果我感覺它只是在抄我XD

後來我直接去複製了Google Pixel 7的手機規格,看看它能寫出什麼東西,結果也只是一再重複而已。

科技的進展,不等於人類的退卻

在Brian Christian所著的《人性較量》中提到,無論對於科技的發展是贊成還是反對,都預設科技的進展等於人類的退卻。尤其因為自己的工作很機械化,而擔心自己會被人工智慧取代的這種想法,被作者認為「搞錯對象」:

「關於『人做的工作被機器搶走』這個過程,其實有個非常重要的過渡階段,那就是人類的工作越來越機械化。雖然藍領和白領都在抱怨機械化的就業環境,但他們鬱悶的是自己的工作乏味至極。把工作樂趣『吸乾』乃至分解成『機器人』行為的過程,很多時候早在科技將這些工作自動化之前就已經發生。所以,問題根源是資本主義的進逼,而不是科技帶來的壓力。工作一旦被這種方式『機械化』,它被機器(或AI)取代似乎也是遲早的事。所以我認為,目前對於AI的恐懼似乎劃錯重點。」

在實際使用AI語言模型,以及讀了一些文獻之後,我突然完全不擔心自己的工作會被人工智慧取代,因為我的工作高度仰賴同理心、價值判斷,以及複雜細膩的情感,我甚至開始覺得,在人工智慧發展得越來越成熟之後,哲學人文的素養,會變得無比重要,因為量化、多工處理、超越人類記憶極限7±2的範疇,都可以交給人工智慧處理,而那些難以預測、變幻莫測、意見分歧的議題,才是我們該重視的部份。

或許透過人工智慧的出現,反而讓我們發現了人類自以為的脆弱,其實也是無比珍貴的特質。

所以接下來該思考的是,自己如何運用這項工具、如何鍛鍊自己的思考能力、如何避免讓自己的工作落於公式化。此外,無論正面還是負面,都珍視自己的情緒和情感,並好好的紀錄,化為寫作的養份。除非哪天AI意識到了自我的存在,否則我大可以拋開科技焦慮,只是第四波人工智慧浪潮,或是人類發展的奇異點,我有生之年,可能無法看見就是了。

Photo by Alexander Sinn on Unsplash